정화 코딩

[논문 리뷰] Towards Multi-modal Transformers in Federated Learning 본문

https://arxiv.org/abs/2404.12467

Towards Multi-modal Transformers in Federated Learning

Multi-modal transformers mark significant progress in different domains, but siloed high-quality data hinders their further improvement. To remedy this, federated learning (FL) has emerged as a promising privacy-preserving paradigm for training models with

arxiv.org

0. Abstract

Multi-modal transformers: 이미지와 텍스트 등 여러 종류의 데이터를 함께 처리하면서 크게 발전 중.

But, 성능 향상을 위해 고품질의 많은 데이터 필요 -> 프라이버시 문제 발생

-> Federated learning (FL): 각 클라이언트가 데이터를 직접 공유하지 않고도 모델을 함께 학습 가능 -> privacy-preserving paradigm

지금까지의 연합학습 연구: 같은 모달리티 데이터를 갖는 클라이언트끼리 연합학습.

But, 현실에는 Unpaired uni-modal clients(어떤 클라이언트는 이미지만 가지고, 어떤 클라이언트는 텍스트만 가짐)가 많음.

-> Transfer multi-modal federated learning (MFL): Transformer 기반의 멀티모달 연합학습

이 논문에서는 vision-language domain(이미지-텍스트)에서 MFL을 연구함.

기존 방법들이 Transformer 구조에서도 잘 동작하는지 평가, FedCola라는 새로운 프레임워크 제안.

Federated modality complementary and collaboration (FedCola): 두 가지 차원에서 클라이언트 간 차이를 조정함.

1) In-modality gap: 같은 모달리티 안에서 클라이언트 간 데이터 차이

2) Cross-modality gap: 이미지 ↔ 텍스트처럼 모달리티가 다른 클라이언트 간 차이

FedCola는 이런 간극을 줄여서 클라이언트들이 서로 협력하고 보완할 수 있도록 함.

1. Introduction

Multi-modal transformers를 잘 학습시키려면 고품질의 많은 데이터가 필요함.

문제 1) resource-intensive: 많은 자원 필요. 2) data silos: 데이터 고립 (프라이버시 때문)

Federated Learning (FL): 연합학습

global 모델을 선택된 클라이언트들에게 전파 -> local training 이후 클라이언트들로부터 모델 업데이트를 받아 global 집계(aggregation) 수행 -> 반복...

=> heterogenous(이질적) data 간의 collaborative training (협력적 학습) 가능, decentralized 방식, 프라이버시 문제와 데이터 고립 문제 해결

기존 FL 연구의 한계

대부분 단일 모달리티 (uni-modal) 데이터만 고려

Multi-modal Federated Learning (MFL): 멀티모달 연합학습

- horizontal (수평) MFL: 모든 클라이언트가 같은 모달리티 가짐. (ex. 모두 이미지+텍스트 데이터 보유)

- vertical (수직) MFL: 같은 사용자의 서로 다른 모달리티가 클라이언트 간에 나뉨. 즉, 클라이언트 별로 하나의 모달리티 가짐. (ex. 한 쪽은 텍스트만, 다른 쪽은 이미지만)

Transfer Multi-modal Federated Learning (Transfer MFL)

unpaired 데이터를 가지는 uni-modal 클라이언트 사이의 연합학습을 위해 등장

문제1) uni-modal (단일 모달리티) 클라이언트의 제한된 데이터 접근성: 유니모달 클라이언트는 다른 모달리티에 접근할 수 없어서 자신의 모달리티에 편향됨 -> cross-modality gap (모달리티 간 격차)

문제2) in-modality gap (동일 모달리티 내 격차): 멀티모달 클라이언트와 유니모달 클라이언트의 학습 목적이 다르기 때문에 발생

해결책: Federated modality Complementary and collaboration (FedCola)

- Local Training 단계에서, 혼합 전략(mixture strategy): 모달리티 보완 정보 사용 (with 가중치 압축)

- Global Aggregation 단계에서, 집계와 분리(aggregation with disaggregation) 전략: 개별 학습 목표에 맞는 지식을 유지하면서 공통된 일반 지식 통합

이 논문의 주요 기여

1. Transfer Multi-modal FL 개념 제안

2. FedCola 프레임워크 설계

3. Cross-modality 지식 공유 가능성 입증

4. 실험적 검증

2. Related Work

2.1. Federated learning (연합학습)

프라이버시를 보호하면서 분산환경에서 학습할 수 있는 접근법

이질성의 종류에 따라,

- Statistical Heterogeneity (통계적 이질성): 클라이언트 별로 도메인과 모달리티는 같아도 다른 데이터 분포를 가짐.

- System Heterogeneity (시스템 이질성): 클라이언트 별로 디바이스 성능, 네트워크 환경 등이 다름.

결과 모델의 목적에 따라,

- Global FL (Global model의 성능): 전체 클라이언트의 데이터를 잘 일반화할 수 있는 모델 학습이 목표.

- Personalized FL (Local model의 성능): 각 클라이언트에 맞는 맞춤형 모델을 만다는 것이 목표.

이 논문의 Focus: modality-level heterogeneity (모달리티 수준의 이질성) + global FL

2.2. Multi-modal FL (멀티모달 연합학습)

서로 다른 모달리티가 공통된 고차원 지식(high-level knowledge)을 공유하면서 공동 학습

초기 연구: 각 모달리티마다 동질적인(homogeneous) 모델 사용

최근 연구: 다양한 소형 클라이언트 모델들로부터 지식을 전이시켜 서버에서 더 큰 모델을 학습, 유니모달 클라이언트와 멀티모달 클라이언트 간의 지식 전이를 통해 이질적인 데이터를 활용한 더 큰 글로벌 모델을 학습

여전히 존재하는 제한을 이 논문이 해결: 어떠한 공개 데이터 사용X, 트랜스포머의 멀티모달 표현력만으로 지식을 전이하는 방법에 집중

2.3. Vision transformers in FL (ViT와 연합학습)

ViT: 중앙 집중형 컴퓨터 비전 분야에서 사실상 표준 아키텍처. But, FL 환경에서는 거의 연구되지 않음.

기존 연구: ViT를 global FL 환경에서 사용, ViT를 personalized FL 환경에서 사용, 사전학습된 ViT를 다양한 FL 환경에서 사용.

이 논문의 Focus: Transformer의 멀티모달 능력과 아키텍처의 통일성에 초점 -> 대규모 연합학습에서의 적용 가능성

3. Transfer MFL

전체 시나리오 요약

vision-language domain(이미지+텍스트 멀티모달 도메인)에서 Transfer MFL

모달리티 조합: 이미지, 텍스트, 이미지+텍스트

FL 시작 준비

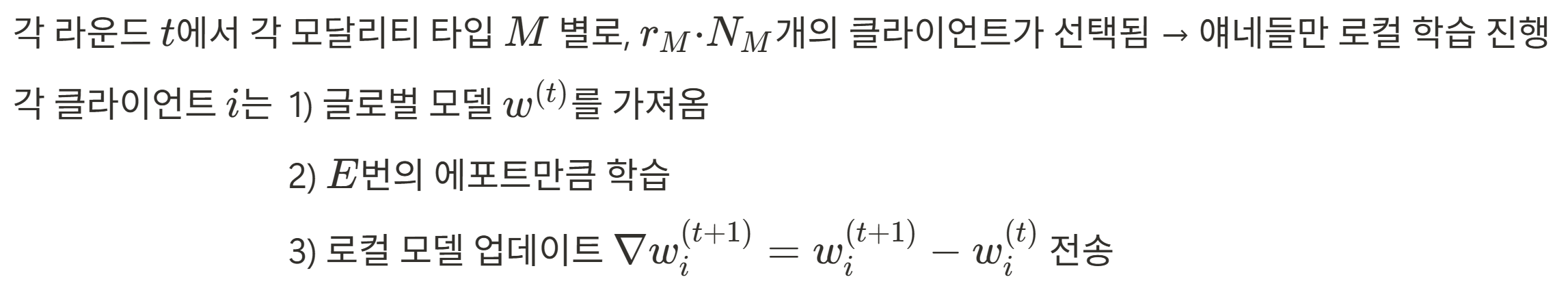

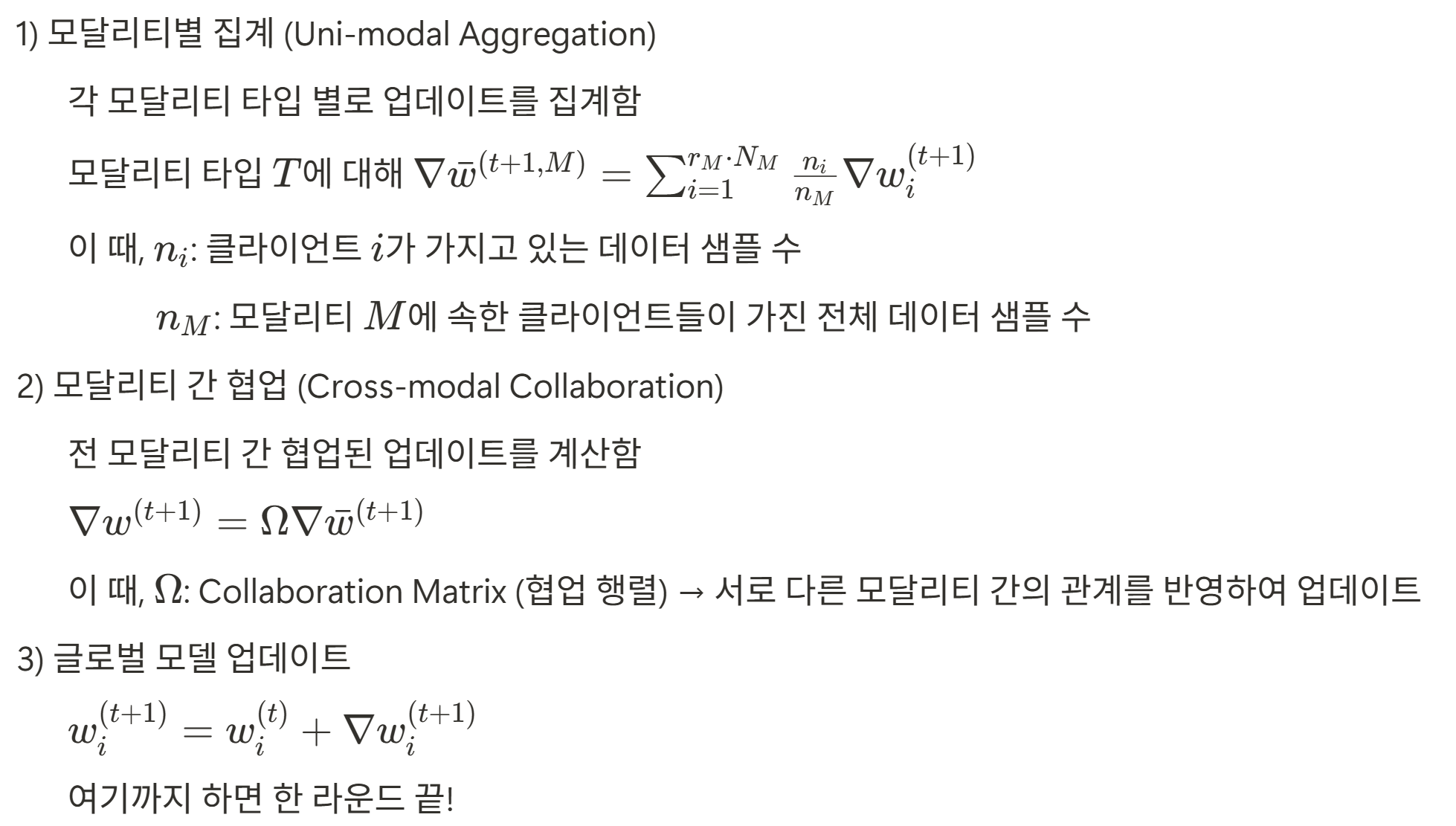

Local Training

Global Aggregation

4. Method

4.1. The Framework

두 가지 간극: Cross-modality gap, In-modality gap

-> 이를 해결하기 위한 주요 목표: 모든 클라이언트의 표현(representation)을 하나의 공유된 피처 공간으로 정렬(unify)하는 것

But, 중앙 집중식 학습과 달리, 연합학습에서는 파라미터만이 지식을 전달하는 매체이기 때문에 직접적인 joint training 불가능

제안하는 핵심 전략

1. Transformer의 통합 아키텍처(unifying architecture) 활용

모델의 세 부분: 1) Embedding layers: 입력 모달리티에 따라 다름. 2) Transformer blocks: 모든 클라이언트가 동일한 구조. 3) Task head: 클라이언트의 학습 목표에 따라 다름.

2. 유니모달 클라이언트에서, 보완 학습(local complementary training) 기법 활용

3. 서버에서, 협력 집계(collaborative aggregation) 기법 활용

4.2. Complementary local training against cross-modality gap

문제점: 유니모달 클라이언트는 자기 모달리티 데이터만 학습 가능, 다른 모달리티 정보 활용 불가능.

해결의 핵심 아이디어

Transformer 구조의 통일성 활용 -> Cross-modal encoding을 통해 다양한 모달리티의 신호를 로컬 학습에 통합 가능

적용 방식

Mixture of Experts (MoE) 개념 차용: 여러 전문가 모델의 레이어가 가중합으로 결합되는 방식

이 논문에서의 변형: 로컬 모달리티 모델을 우선순위 높게 반영, 다른 모달리티 모델은 보조적인 역할로 반영

이를 위해 게이트 파라미터 g 도입 (학습 가능한 파라미터) -> 로컬 정보와 외부 정보의 결합 정도 조절

처음에는 g=0 (외부 정보 무시) -> g 학습 (외부 정보를 로컬 모달리티에 얼마나 반영할 것인지)

문제점: 통신량 증가 (모델 파라미터 수 증가, 업로드 통신 비용 증가)

해결 방법: 압축 (Compression) 기법 (선형성을 이용하여 업로드하는 최종 가중치는 원래 크기로 유지)

4.3. Collaborative aggregation against in-modality gap

문제점: 같은 모달리티를 사용하는 클라이언트도 학습 목적이 다르면(distinct local objectives) 모델 파라미터에 담긴 정보가 다름 -> 단순 집계 방식(uniform aggregation approach)은 개별 로컬 과업에 특화된 지식을 희석시킬 위험이 있음

해결의 핵심 아이디어

Insight (통찰): Transformer 구조에서, Self-Attention 레이어 -> 일반화된 지식(general knowledge) 학습 / MLP -> 도메인 특화 지식(domain-specific knowledge) 학습

=> Self-Attention 레이어에 대해서만 선택적으로 집계(selective aggregation)를 수행, 나머지 구성요소(ex. MLP)에 대해서는 분리(disaggregation) 전략을 적용 -> in-modal collaboration (모달리티 내 협력)

But, 협력 집계가 적용된 모델 가중치와 그렇지 않은 모델 가중치 간의 불일치(misalignment) 문제: 레이어 수준의 불일치(layer-level misalignment), 모달리티 수준의 불일치(modality-level misalignment)

-> 이를 해결하기 위해 Compensation(보상) Scheme: 협력이 이루어지지 않은(non-collaborated) 레이어에 대해서도 Self-Attention 레이어와 동일한 계수로 업데이트를 스케일링

-> 동일 모달리티 내 격차(in-modality gap) 감소

5. Experiments

1) Datasets (데이터셋 구성)

- image 클라이언트를 위한 image 데이터: CIFAR-100

- test 클라이언트를 위한 text 데이터: AG NEWS

- 성능 평가용: Flickr30k, COCO Captions

- 멀티모달과 유니모달 클라이언트간 도메인 격차 분석용: OrganCMNIST, Medical Abstract

2) FL Settings (연합학습 설정)

- 클라이언트 수: 이미지 12, 텍스트 12, 멀티모달 8

- 데이터 분배: Dirichlet 분포 (α = 0.5), 클라이언트 간 non-IID

- 참여 비율: r = 0.25

- 로컬 학습: 5 epoch / 총 라운드 수: T = 30

- 추가 설정 1) More Heterogeneity: α = 0.1로 더 불균형한 데이터 분포

- 추가 설정 2) Less Participation: 참여 비율 r = 0.125로 감소

3) Model Architecture (모델 구조)

- Transformer blocks: ViT-Small 사용

- 이미지: patch embedding

- 텍스트: BERT tokenizer

4) 비교 방법들 (Comparison Methods)

- Uni-modal methods: FedAvg, FedProx

- Adapted Multi-modal FL methods: CreamFL, FedIoT

5) Evaluation Metrics (평가 기준)

Top-1 Recall 합산 (이미지->텍스트 & 텍스트->이미지)

5.1. Evaluation under different FL settings

- 기본 설정 (default): FedCola가 가장 높은 성능을 보이며 모든 baseline(FedAvg, FedProx, CreamFL, FedIoT)보다 우수함

- 더 높은 이질성 (α=0.1): 성능 유지, FedCola의 강인함 입증

- 낮은 참여율 (r=0.125): 성능 하락 적음, 다른 방법들보다 훨씬 안정적

- 이미지/텍스트 클라이언트 증가: 다소 불균형한 환경에서도 FedCola가 꾸준한 성능 향상

- 멀티모달 클라이언트 감소: 여전히 FedCola가 가장 우수, 불균형 aggregation 환경에서도 강인함 유지

=> FedCola는 참여 비율/데이터 이질성/모달리티 구성 변화에도 강건하게 동작하며, 모든 환경에서 일관되게 가장 좋은 성능을 보여줌.

5.2. Evaluation under different domain gaps

- FedCola: 모든 도메인 갭 상황에서도 가장 높은 성능, 다만 도메인 갭이 커질수록 성능은 일부 감소함

- FedIoT: 도메인 갭이 커질수록 성능 급락, 멀티모달 클라이언트 의존도가 높기 때문

- CreamFL: 성능은 안정적이나 FedAvg보다 항상 좋은 것은 아님, 공개 데이터 기반 협업 구조 때문

=> FedCola는 도메인 간 데이터 차이가 클 때도 가장 높은 성능과 안정성을 보이며, 다른 방법들보다 도메인 일반화에 강함. 하지만 도메인 갭이 너무 클 경우 여전히 도전 과제가 존재함.

6. Discussion

6.1. Ablation study (구성 요소별 성능 분석)

Impact of each module (각 모듈의 성능 기여 분석)

- Self-attention 협업만으로도 큰 성능 향상

- 계층 정렬 보정으로 좀 더 안정적인 집계

- 마지막으로 크로스모달 보완 학습까지 추가하자 최고 성능 도달

Designs for complementary local training (보완 학습 설계 분석)

- 모든 block을 사용하지 않고, Self-attention block만 사용 -> 성능 대비 통신 비용 최적화

Designs on collaborative aggregation (협력 집계 설계 분석)

- 협업은 Self-Attention 계층에만, 같은 모달리티 클라이언트끼리만 하는 것이 가장 효과적

6.2. Fairness analysis (공정성 분석)

FL에서는 클라이언트마다 목표가 다름 -> 유니모달 클라이언트의 성능 기여도를 정량화하고, 수익 분배 기준을 제공하기 위해

Performance on uni-modal tasks (유니모달 작업 성능 유지 여부)

- FedCola는 협업하면서도 개별 클라이언트의 목적까지 배려하는 "공정한 협업"을 실현

Quantifying the contributions of uni-modal clients (유니모달 클라이언트의 기여도 정량화)

- 텍스트 클라이언트가 더 큰 기여를 했고, 따라서 공정한 수익 분배라면 텍스트 클라이언트에게 더 많은 보상이 돌아가야 함

6.3. Scaling-up capability (확장성 분석)

- 더 많은 유니모달 데이터셋을 포함시킬수록 멀티모달 성능이 향상

- 즉, 데이터 다양성이 많아질수록 전체 모델이 더 일반화됨

-> FedCola는 스케일 확장에 강한 구조 (새로운 클라이언트나 도메인이 추가되더라도 성능 향상 가능)

7. Conclusion

목표: Transfer Multi-modal Federated Learning (MFL) 환경에서의 성능 개선

모델 구조: Transformer 기반 구조에 집중

핵심 기법: 1) Complementary Local Training, 2) Collaborative Aggregation

기여: 다양한 실험을 통해 FedCola가 기존 방식보다 우수한 성능을 보임. 특히, 도메인 간 차이(domain gap)나 클라이언트 수의 변화 같은 현실적인 조건에서도 강인함.

의의: FL 내에서 Transformer 기반 멀티모달 협업 구조의 가능성 제시. 다양한 클라이언트 유형 간 기여도 분석 및 수렴 조건에 대한 새로운 인사이트 제공. 향후 대형 트랜스포머 학습을 위한 멀티모달 연합학습 연구 방향을 여는 기반 제공

'AI' 카테고리의 다른 글

| MDETR 모델 주요 코드 분석 (0) | 2025.07.18 |

|---|---|

| [논문 리뷰] FedMSplit: Correlation-Adaptive Federated Multi-Task Learning across Multimodal Split Networks (2) | 2025.07.11 |

| [논문 리뷰] MDETR - Modulated Detection for End-to-End Multi-Modal Understanding (0) | 2025.07.03 |

| [AI] 졸업 프로젝트 PreView: AI 서버 구축, RAG 초기 세팅 후 백엔드 API와 연결 (0) | 2025.05.19 |

| [AI] 졸업 프로젝트 PreView: GPT-4o fine-tuning하여 자기소개서 첨삭 모델 만들기 (0) | 2024.11.26 |